Comment résoudre le problème "Sitemap Couldn't Fetch Issue" dans Google Search Console : Un guide détaillé

Suivez mon blog sur Bloglovin

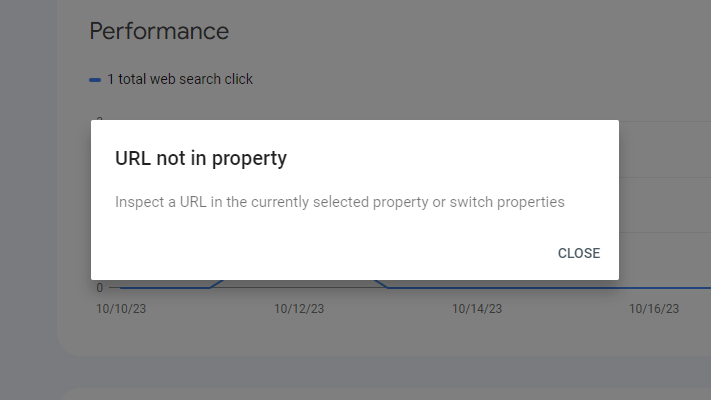

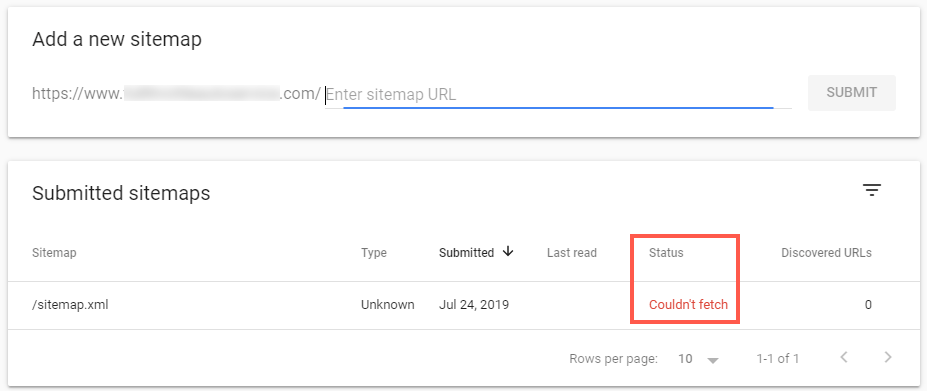

L'erreur "sitemap couldn't fetch" dans Google Search Console peut être un obstacle frustrant pour les webmasters et les professionnels du référencement.

Ce guide complet vous guidera à travers les causes communes de ce problème et vous fournira des solutions avancées pour vous assurer que votre sitemap est correctement exploré et indexé par Google.

Comprendre le problème

Lorsque la Search Console de Google indique qu'elle n'a pas pu récupérer votre sitemap, cela signifie que les robots d'exploration du moteur de recherche n'ont pas pu accéder au fichier sitemap que vous avez soumis, ni le traiter. Cela peut avoir plusieurs conséquences négatives sur le référencement de votre site :

- Réduction de l'efficacité de la marche à quatre pattes

- Indexation retardée du contenu nouveau ou mis à jour

- Perte potentielle de visibilité dans les moteurs de recherche organiques

- Vous avez oublié de créer un sitemap

Causes communes et solutions avancées

1. Il n'existe pas de plan du site

Problème :

La cause la plus fondamentale de l'erreur "sitemap couldn't fetch" peut être qu'aucun sitemap n'a encore été créé pour le site web.

Solutions :

- Vérifiez si un sitemap existe réellement à l'URL que vous avez soumise à Google Search Console. saisissez dans la barre de recherche : https://yourwebsite.com/sitemap.xml

- S'il n'existe pas de sitemap, créez-en un en utilisant l'une des méthodes suivantes :

- Utilisez l'outil de génération de sitemap intégré à votre système de gestion de contenu (de nombreux systèmes de gestion de contenu modernes sont dotés de cette fonction).

- Utilisez les outils de génération de sitemap en ligne pour les sites web de petite et moyenne taille.

- Développer un script de génération de sitemap personnalisé pour les sites web plus importants et plus complexes.

- Créer manuellement un sitemap pour les très petits sites web (non recommandé pour les sites plus importants).

- Veillez à ce que le plan du site respecte le schéma XML défini par sitemaps.org.

- Après avoir créé le plan du site, placez-le dans le répertoire racine de votre site web ou dans un sous-répertoire logique.

- Soumettez la nouvelle URL du sitemap à Google Search Console.

2. Problèmes de configuration du serveur

Problème :

Il se peut que votre serveur bloque les robots d'exploration de Google ou qu'il réponde par des erreurs.

Solutions avancées :

- Mettre en place des listes de contrôle d'accès (ACL) basées sur l'IP pour s'assurer que les plages d'adresses IP de Google sont autorisées.

- Configurez votre serveur de manière à ce qu'il puisse gérer des taux d'exploration élevés sans déclencher de mesures de sécurité.

- Utilisez des outils d'analyse de journaux pour identifier et déboguer les réponses du serveur aux requêtes de Googlebot.

3. Restrictions du fichier Robots.txt

Problème :

Il se peut que votre fichier robots.txt bloque par inadvertance l'accès à votre sitemap.

Solutions avancées :

- Mettre en œuvre une stratégie de robots.txt par étapes à l'aide de configurations spécifiques à l'environnement.

- Utilisez des expressions régulières dans votre fichier robots.txt pour créer des règles d'exploration plus granulaires.

- Tirer parti de la

Plan du site :dans le fichier robots.txt pour déclarer explicitement l'emplacement des sitemaps.

4. Questions relatives au format et à la structure du plan du site

Problème :

Il se peut que votre sitemap ne respecte pas le schéma XML approprié ou qu'il contienne des URL non valides.

Solutions avancées :

- Mettez en place une génération dynamique de sitemap liée à votre système de gestion de contenu (CMS).

- Utiliser XSLT pour transformer des structures de données complexes en formats de plans de site valides.

- Mise en œuvre de la pagination pour les sitemaps de grande taille (>50 000 URL) à l'aide de fichiers d'index de sitemap.

5. Cohérence des URL et canonisation

Problème :

Des formats d'URL incohérents ou une canonicalisation incorrecte peuvent perturber les robots d'indexation.

Solutions avancées :

- Mettre en œuvre la normalisation des URL au niveau du serveur à l'aide de règles de réécriture d'URL.

- Utiliser le

lienavec l'élémentrel="canonical"pour définir explicitement les versions d'URL préférées. - Tirer parti de la

hreflangpour le contenu internationalisé afin d'éviter les problèmes de contenu dupliqué.

6. Problèmes de performance et de délai d'attente

Problème:

La lenteur des temps de réponse du serveur peut entraîner l'interruption des tentatives de recherche.

Solutions :

- Mettre en œuvre des stratégies de mise en cache spécifiquement pour les fichiers sitemap afin de réduire le temps de génération.

- Utilisez les CDN ou la mise en cache en périphérie pour servir les sitemaps à partir d'emplacements géographiquement distribués.

- Optimiser les requêtes de base de données utilisées pour la génération de sitemap dynamiques afin de réduire les temps de chargement.

7. HTTPS et problèmes liés aux certificats SSL

Problème :

Les certificats SSL invalides ou expirés peuvent empêcher la récupération sécurisée des sitemaps.

Solutions :

- Mettre en place des processus automatisés de renouvellement du SSL pour éviter l'expiration.

- Utilisez les en-têtes HSTS (HTTP Strict Transport Security) pour renforcer les connexions HTTPS.

- Mettre en œuvre les versions SSL/TLS et les suites de chiffrement appropriées pour une sécurité et une compatibilité optimales.

Techniques avancées de dépannage

- Analyse du journal: Utilisez des outils comme ELK Stack (Elasticsearch, Logstash, Kibana) ou Splunk pour analyser les journaux de serveur et identifier des modèles dans le comportement de crawl de Googlebot.

- Surveillance du réseau: Mise en œuvre de la capture et de l'analyse de paquets pour diagnostiquer les problèmes au niveau du réseau, afin d'assurer une communication correcte entre votre serveur et les robots d'indexation de Google.

- Surveillance synthétique: Mettez en place des services de surveillance externes qui simulent les requêtes de Googlebot afin d'identifier de manière proactive les problèmes de récupération avant qu'ils n'aient une incidence sur les rapports de la Search Console.

- Intégration de l'API: Exploiter l'API de la Search Console de Google pour soumettre des sitemaps de manière programmatique et surveiller l'état de la récupération, ce qui permet d'établir des rapports automatisés et de détecter les problèmes.

- Test A/B des plans de situation: Mettez en place un système permettant de proposer différentes versions du sitemap à Googlebot, ce qui vous permettra de tester et d'optimiser les structures du sitemap sans avoir d'incidence sur les résultats de recherche en direct.

Conclusion

La résolution du problème "sitemap couldn't fetch" nécessite une approche multidimensionnelle qui porte sur la configuration du serveur, la structure du contenu et l'optimisation des performances.

En mettant en œuvre ces solutions avancées et en exploitant des techniques de dépannage sophistiquées, vous pouvez vous assurer que vos sitemaps sont toujours accessibles aux robots d'indexation de Google, ce qui améliore la visibilité de votre site sur les moteurs de recherche et ses performances globales en matière de référencement.

N'oubliez pas que l'optimisation du sitemap est un processus continu. Surveillez régulièrement les rapports de votre Search Console, tenez-vous informé des modifications apportées aux algorithmes d'exploration et d'indexation de Google et soyez prêt à adapter vos stratégies en fonction des besoins pour maintenir des performances optimales.

Suivez mon blog avec Bloglovin

![Comment corriger l'erreur "Votre plan du site semble être une page HTML" [Prouvé]. Comment corriger l'erreur "Votre plan du site semble être une page HTML" [Prouvé].](https://www.wpconsults.com/wp-content/uploads/2024/05/Html-sitemap-errorl-768x432.png)