Wie man das Problem "Sitemap konnte nicht abgerufen werden" in der Google Search Console löst: Eine ausführliche Anleitung

Folgen Sie meinem Blog auf Bloglovin

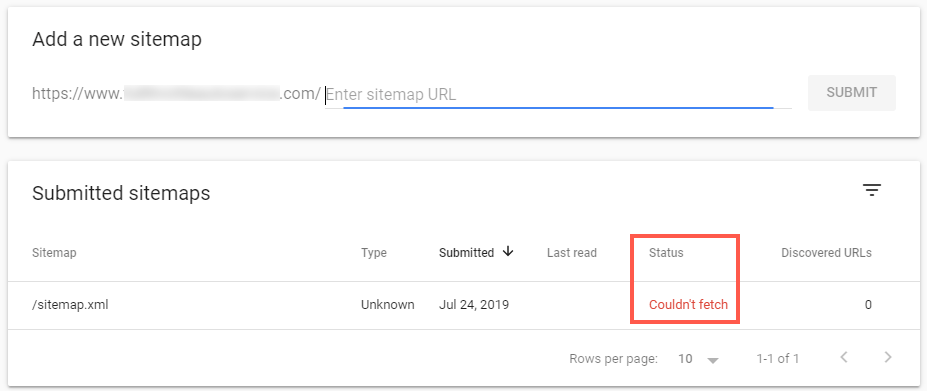

Der Fehler "Sitemap konnte nicht abgerufen werden" in der Google Search Console kann ein frustrierendes Hindernis für Webmaster und SEO-Experten sein.

Dieser umfassende Leitfaden führt Sie durch die häufigsten Ursachen dieses Problems und bietet fortschrittliche Lösungen, um sicherzustellen, dass Ihre Sitemap ordnungsgemäß gecrawlt und von Google indiziert wird.

Das Problem verstehen

Wenn die Google Search Console meldet, dass Ihre Sitemap nicht abgerufen werden konnte, bedeutet dies, dass die Crawler der Suchmaschine nicht auf die von Ihnen übermittelte Sitemap-Datei zugreifen oder sie verarbeiten konnten. Dies kann mehrere negative Auswirkungen auf die Suchmaschinenoptimierung Ihrer Website haben:

- Verminderte Kriecheffizienz

- Verzögerte Indizierung von neuen oder aktualisierten Inhalten

- Möglicher Verlust der Sichtbarkeit in der organischen Suche

- Sie haben vergessen, eine Sitemap zu erstellen

Häufige Ursachen und fortschrittliche Lösungen

1. Keine Sitemap vorhanden

Problem:

Die Hauptursache für den Fehler "Sitemap couldn't fetch" könnte sein, dass noch keine Sitemap für die Website erstellt wurde.

Lösungen:

- Prüfen Sie, ob unter der URL, die Sie an die Google Search Console übermittelt haben, tatsächlich eine Sitemap vorhanden ist. in die Suchleiste eingeben: https://yourwebsite.com/sitemap.xml

- Wenn keine Sitemap existiert, erstellen Sie eine mit einer der folgenden Methoden:

- Verwenden Sie das in Ihrem Content Management System eingebaute Tool zur Erstellung einer Sitemap (viele moderne CMS-Plattformen verfügen über diese Funktion).

- Verwenden Sie Online-Sitemap-Generator-Tools für kleine bis mittelgroße Websites.

- Entwicklung eines benutzerdefinierten Skripts zur Erstellung von Sitemaps für größere, komplexere Websites.

- Manuelle Erstellung einer Sitemap für sehr kleine Websites (nicht empfohlen für größere Websites).

- Stellen Sie sicher, dass die Sitemap dem korrekten XML-Schema entspricht, das von sitemaps.org definiert wurde.

- Nachdem Sie die Sitemap erstellt haben, legen Sie sie im Stammverzeichnis Ihrer Website oder in einem logischen Unterverzeichnis ab.

- Übermitteln Sie die neue Sitemap-URL an die Google Search Console.

2. Probleme mit der Serverkonfiguration

Problem:

Möglicherweise blockiert Ihr Server die Crawler von Google oder antwortet mit Fehlern.

Fortgeschrittene Lösungen:

- Implementieren Sie IP-basierte Zugriffskontrolllisten (ACLs), um sicherzustellen, dass die IP-Bereiche von Google zugelassen sind.

- Konfigurieren Sie Ihren Server so, dass er hohe Crawl-Raten verarbeiten kann, ohne Sicherheitsmaßnahmen auszulösen.

- Verwenden Sie Tools zur Protokollanalyse, um Serverantworten auf Googlebot-Anfragen zu identifizieren und zu beheben.

3. Robots.txt-Einschränkungen

Problem:

Möglicherweise blockiert Ihre robots.txt-Datei versehentlich den Zugriff auf Ihre Sitemap.

Fortgeschrittene Lösungen:

- Implementieren Sie eine abgestufte robots.txt-Strategie mit umgebungsspezifischen Konfigurationen.

- Verwenden Sie reguläre Ausdrücke in Ihrer robots.txt, um detailliertere Crawl-Regeln zu erstellen.

- Nutzen Sie die

Sitemap:Direktive in der robots.txt, um die Standorte der Sitemaps explizit anzugeben.

4. Probleme mit Format und Struktur der Sitemap

Problem:

Ihre Sitemap entspricht möglicherweise nicht dem richtigen XML-Schema oder enthält ungültige URLs.

Fortgeschrittene Lösungen:

- Implementieren Sie eine dynamische Sitemap-Generierung, die mit Ihrem Content-Management-System (CMS) verknüpft ist.

- Verwenden Sie XSLT, um komplexe Datenstrukturen in gültige Sitemap-Formate umzuwandeln.

- Implementierung einer Paginierung für große Sitemaps (>50.000 URLs) unter Verwendung von Sitemap-Indexdateien.

5. URL-Konsistenz und Kanonisierung

Problem:

Inkonsistente URL-Formate oder unsachgemäße Kanonisierung können Crawler verwirren.

Fortgeschrittene Lösungen:

- Implementieren Sie die URL-Normalisierung auf Serverebene mithilfe von URL-Rewriting-Regeln.

- Verwenden Sie die

LinkElement mitrel="kanonisch"um explizit bevorzugte URL-Versionen zu definieren. - Nutzen Sie die

hreflangAttribut für internationalisierte Inhalte, um Probleme mit doppeltem Inhalt zu vermeiden.

6. Leistung und Timeout-Probleme

Problem:

Langsame Antwortzeiten des Servers können dazu führen, dass Abrufversuche zeitlich verzögert werden.

Lösungen:

- Implementieren Sie Caching-Strategien speziell für Sitemap-Dateien, um die Generierungszeit zu verkürzen.

- Verwenden Sie CDNs oder Edge Caching, um Sitemaps von geografisch verteilten Standorten aus bereitzustellen.

- Optimieren Sie die Datenbankabfragen, die bei der dynamischen Sitemap-Erstellung verwendet werden, um die Ladezeiten zu verkürzen.

7. Probleme mit HTTPS- und SSL-Zertifikaten

Problem:

Ungültige oder abgelaufene SSL-Zertifikate können das sichere Abrufen von Sitemaps verhindern.

Lösungen:

- Implementieren Sie automatisierte SSL-Erneuerungsprozesse, um ein Ablaufen zu verhindern.

- Verwenden Sie HSTS-Header (HTTP Strict Transport Security), um HTTPS-Verbindungen zu erzwingen.

- Implementieren Sie die richtige SSL/TLS-Version und Cipher Suites für optimale Sicherheit und Kompatibilität.

Fortgeschrittene Techniken zur Fehlersuche

- Log-Analyse: Verwenden Sie Tools wie ELK Stack (Elasticsearch, Logstash, Kibana) oder Splunk, um Serverprotokolle zu analysieren und Muster im Crawl-Verhalten von Googlebot zu erkennen.

- Netzwerk-Überwachung: Implementieren Sie die Erfassung und Analyse von Datenpaketen, um Probleme auf Netzwerkebene zu diagnostizieren und die korrekte Kommunikation zwischen Ihrem Server und den Crawlern von Google sicherzustellen.

- Synthetische Überwachung: Richten Sie externe Überwachungsdienste ein, die Googlebot-Anfragen simulieren, um proaktiv Abrufprobleme zu erkennen, bevor sie sich auf Ihre Search Console-Berichte auswirken.

- API-Integration: Nutzen Sie die Google Search Console API, um Sitemaps programmatisch zu übermitteln und den Abrufstatus zu überwachen, was eine automatische Berichterstattung und Problemerkennung ermöglicht.

- A/B-Tests für Sitemaps: Implementieren Sie ein System, das dem Googlebot verschiedene Sitemap-Versionen zur Verfügung stellt, so dass Sie die Sitemap-Strukturen testen und optimieren können, ohne dass dies Auswirkungen auf die Live-Suchergebnisse hat.

Schlussfolgerung

Die Lösung des Problems "Sitemap konnte nicht abgerufen werden" erfordert einen vielschichtigen Ansatz, der die Serverkonfiguration, die Inhaltsstruktur und die Leistungsoptimierung berücksichtigt.

Durch die Implementierung dieser fortschrittlichen Lösungen und die Nutzung ausgefeilter Techniken zur Fehlerbehebung können Sie sicherstellen, dass Ihre Sitemaps für die Crawler von Google durchgängig zugänglich sind, und so die Sichtbarkeit Ihrer Website in den Suchmaschinen und die allgemeine SEO-Leistung verbessern.

Denken Sie daran, dass die Sitemap-Optimierung ein fortlaufender Prozess ist. Überwachen Sie regelmäßig Ihre Search Console-Berichte, bleiben Sie auf dem Laufenden über Änderungen an den Crawling- und Indexierungsalgorithmen von Google und seien Sie darauf vorbereitet, Ihre Strategien bei Bedarf anzupassen, um eine optimale Leistung aufrechtzuerhalten.

Folgen Sie meinem Blog mit Bloglovin

![Wie man den Fehler "Ihre Sitemap scheint eine HTML-Seite zu sein" behebt [Bewährt] Wie man den Fehler "Ihre Sitemap scheint eine HTML-Seite zu sein" behebt [Bewährt]](https://www.wpconsults.com/wp-content/uploads/2024/05/Html-sitemap-errorl-768x432.png)